Working for the Screw to Fit

Article within the current edition of the KIT magazine lookKIT on information at the Karlsruhe Institute of Technology, Edition 1/2017. The text was written in German, an excerpt is available in English at the end of the text.

Unzählige Daten werden tagtäglich in Industrie und öffentlichem Leben erfasst und gespeichert. Professor Klemens Böhm vom Lehrstuhl für Systeme der Informationsverwaltung am KIT interessiert sich für diese Datenbestände: „Wir möchten die Zusammenhänge, die sich hier verbergen, herausarbeiten und nutzbar machen.“Schon lange bevor Begriffe wie Big Data und Data Science in aller Munde waren, haben Böhm und sein Team solche Datenbestände in ihren wissenschaftlichen Fokus genommen. Sie analysieren sie mithilfe von Data-Mining-Techniken, oft in Zusammenarbeit mit Industrieunternehmen oder anderen Forschergruppen. Die Ergebnisse ihrer Arbeit gehen in die Grundlagenforschung ein, haben aber auch stets einen konkreten Anwenderbezug und -nutzen.

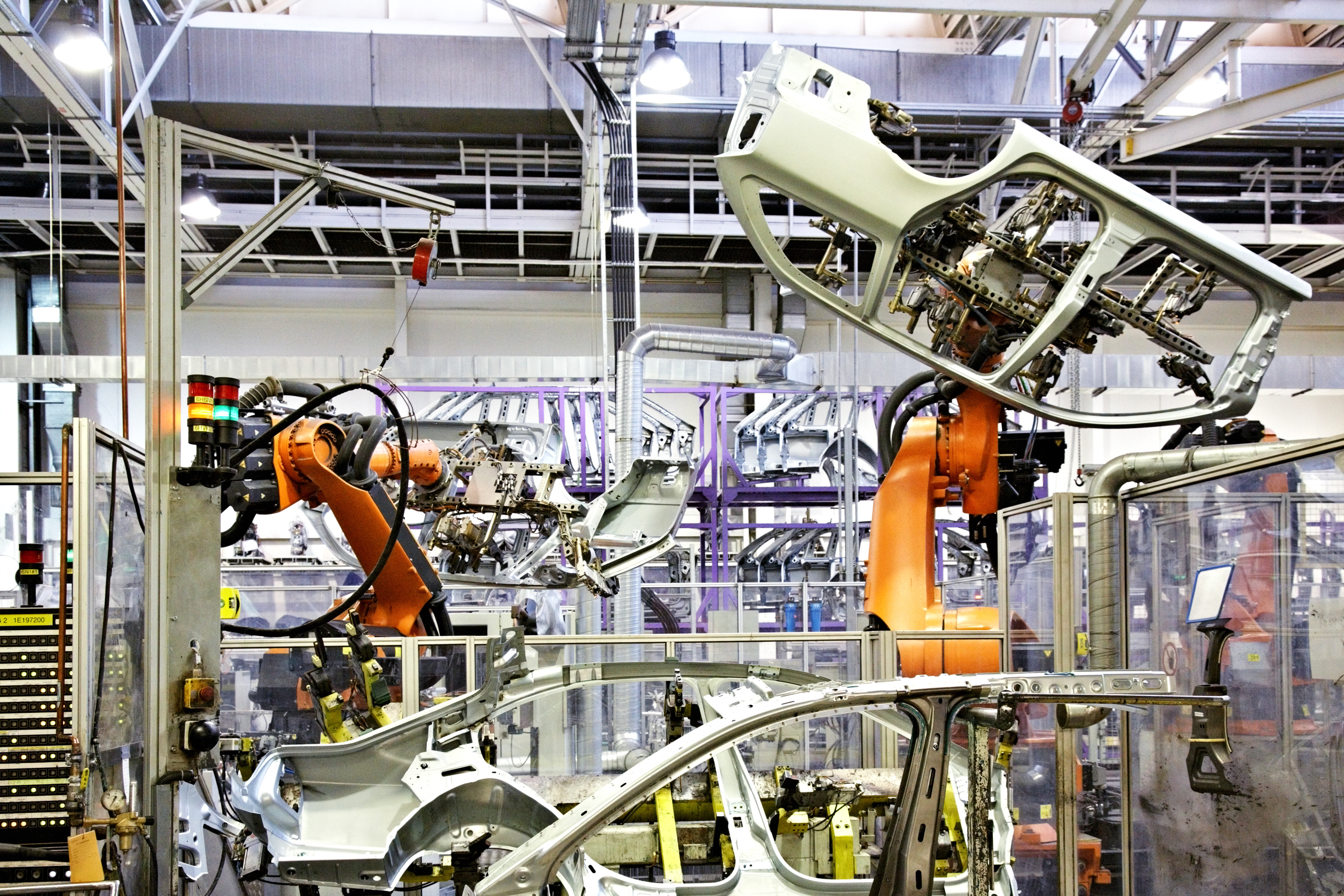

Ein Beispiel für eine solche Aktivität ist eine erfolgreiche Kooperation zwischen dem Lehrstuhl von Professor Böhm und dem Autohersteller AUDI AG. Gegenstand der Untersuchung war die Montage von Sicherheitsgurten, die ein Arbeiter mit einem modernen Schraubwerkzeug durchführt. Dieser Prozess wird kontinuierlich überwacht, die anfallenden Daten werden erfasst. Die Daten sind Zeitreihen, die insbesondere die Größen Drehmoment (Stärke des Schraubvorgangs) und Drehwinkel (Lage der Schraube beim Schraubvorgang) jeweils zu bestimmten Zeitpunkten umfassen. Die Überwachung stellt sicher, dass während der Verschraubung bestimmte Grenzwerte stets eingehalten werden, die erfahrene Anwendungsexperten vorher festgelegt haben, zum Beispiel dass die geforderten Anzugsdrehmomente immer ereicht werden. Verletzt ein Schraubvorgang einen Grenzwert, so wird dieser abgebrochen. Je früher ein Schraubvorgang als fehlerhaft erkannt wird, desto eher kann er abgebrochen werden. Das führt zu reduziertem Zeit- und Materialeinsatz und senkt die Produktionskosten.

Aufgrund einer Dokumentationspflicht dieser sicherheitsrelevanten Verschraubungen verfügt die AUDI AG über einen großen Pool entsprechender Produktionsdaten. Die Frage war nun, ob sich aus diesen ursprünglich ausschließlich zur Dokumentation erfassten und archivierten Daten verlässliche Kriterien ableiten ließen, die einen fehlerhaften Schraubvorgang noch früher und zuverlässiger erkennen können, als dies die händisch festgelegten Grenzwerte ermöglichen. AUDI AG stellte dem Lehrstuhl Daten zu ca.30 000 Schraubvorgängen zur Analyse zur Verfügung. Das Team um Professor Böhm analysierte die Daten mit dem Ziel, die Übereinstimmung von jeweils zwei Zeitreihen zu quantifizieren, und entschied sich für ein hierfür geeignetes Abstandsmaß. Die anschließende Anwendung eines Clustering-Verfahrens konnte Cluster von Zeitreihen mit hoher struktureller Ähnlichkeit identifizieren. Auf diesem Weg ließen sich auch Schraubvorgänge identifizieren, die sich signifikant von fast allen anderen unterschieden. Dies führte zur Entdeckung eines neuen Kriteriums, das weniger „falsche Alarme“ lieferte, gleichzeitig aber tatsächliche Fehler früher erkennen lässt. Neben der direkten Anwendbarkeit führten die Ergebnisse beim Auftraggeber zu tieferem Verständnis von Schraubvorgängen.

Auch in weiteren Projekten konnte das Team neues Wissen aus vorhandenen Daten generieren, so für das KIT-interne Facility Management, das durch den Einsatz von intelligenten Strommessgeräten über große Datenbestände verfügt. Oder bei der Suche nach Fehlern in neu programmierter Software: Lässt man zum Test neue Programme mit unterschiedlichen Parametern laufen, kann man unter bestimmten Voraussetzungen stark eingrenzen, an welchen Stellen in der Programmierung sich Fehler eingeschlichen haben. Im Rahmen eines EU-Projektes ist Böhms Arbeitsgruppe auch an der Analyse von Schiffsmotoren beteiligt. Die Temperaturmessung an vielen unterschiedlichen Stellen im Motor soll frühzeitig Schadensfälle detektieren.

„Auch wenn in jedem Projekt die Herausforderungen anders sind und eine individuelle Ausgestaltung erforderlich machen, haben wir in den vergangenen Jahren Erkenntnisse gewonnen, wie an solche Projekte heranzugehen ist”, so Böhm. Für ihn sind folgende Punkte entscheidend:

Möglichst enge Einbindung des Anwenders:

Den Anwender nur als „Datenlieferanten“ zu sehen, greift zu kurz. Als Experte, der Ergebnisse und Lösungen bewertet, trägt er oft viel mehr zum Erfolg eines Datenanalyseprojekts bei und ist unabdingbar.

Realistische Ziele - und entsprechende Absprachen:

Falsche Erwartungen können ein an sich erfolgreich abgeschlossenes Projekt subjektiv als Misserfolg erscheinen lassen. Aber auch der umgekehrte Effekt ist möglich, dass niedrige Erwartungen am Ende des Tages zu einer positiven anwenderseitigen Erfahrung führen. Im Vorfeld muss mit dem Anwender unter allen Umständen klar abgesprochen werden, welche Ergebnisse gewünscht und welche realistisch sind.

Merkmalauswahl entscheidend:

Die Auswahl des Verfahrens, das die Daten analysiert, ist nicht die wichtigste Entscheidung. Oft führen unterschiedliche Wege zum Ziel, und aus Anwendersicht unterscheiden sich in manchen Fällen einzelne Algorithmen nur um Nuancen. Die Frage, welche Merkmale des zugrunde liegenden Systems man letztendlich betrachtet, scheint hingegen in vielen Fällen ausschlaggebend zu sein und muss in Projekten angemessenen Raum bekommen.

Beschaffenheit der Daten oft wichtiger als Datenvolumen:

Anwenderseitige Ideen für Projekte lassen sich auf Grundlage der zur Verfügung gestellten Daten mitunter gar nicht durchführen. Man muss so früh wie möglich, schon im Vorfeld auf die Verfügbarkeit der richtigen Daten achten. Im Industriekontext ist hingegen das Datenvolumen – nicht immer, aber in unerwartet vielen Fällen – eher zweitrangig.

Böhms vielleicht wichtigstes Ziel bei der Durchführung von Projekten ist es, sowohl die Anwender zufriedenzustellen als auch aus dem Szenario grundlegende Forschungsfragen zu isolieren, die insbesondere Doktoranden des Lehrstuhls wissenschaftlich bearbeiten können. Als Mega-Forschungsthema der Zukunft sieht Böhm die Datenqualität. Derzeit treibt ihn die Frage um, welche Datenqualität erforderlich ist, damit bestimmte Analysen möglich sind. Datenqualität hat viele Facetten, zum Beispiel die Auflösung (Anzahl Messungen pro Zeiteinheit) oder die Aktualität der Daten. Böhm ist überzeugt, dass Antworten auf diese Frage Anwendern, insbesondere in der Industrie, helfen werden, ihre Infrastruktur zur Datenerfassung angemessen zu planen und zu dimensionieren und so langfristig zu erheblich erfolgreicheren Datenanalyseprojekten führen.

In der industriellen Fertigung werden an vielen Stellen Daten zwar erhoben, derzeit aber noch nicht systematisch ausgewertet. „Hier sehe ich ein großes Potenzial für die Zusammenarbeit zwischen Industrie und Datenanalyseexperten – wir können unsere Erfahrungen sehr gut einbringen“, sieht sich Böhm für zukünftige Herausforderungen gut vorbereitet.